Sitemap XML: как увеличить трафик креативным подходом к карте сайта

Вебмастер Оливер Мейсон поделился у себя в блоге с читателями интересной информацией, касающейся Sitemap XML. Оказывается, карта сайта, при альтернативном подходе к ней, может стать источником дополнительного трафика.

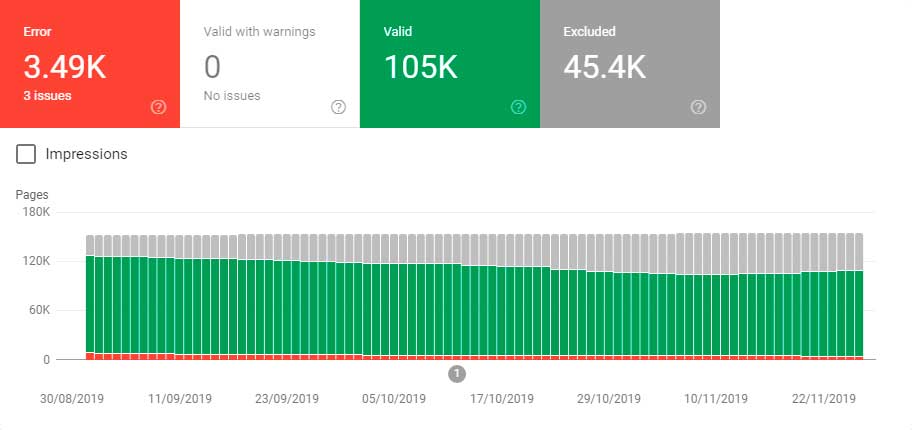

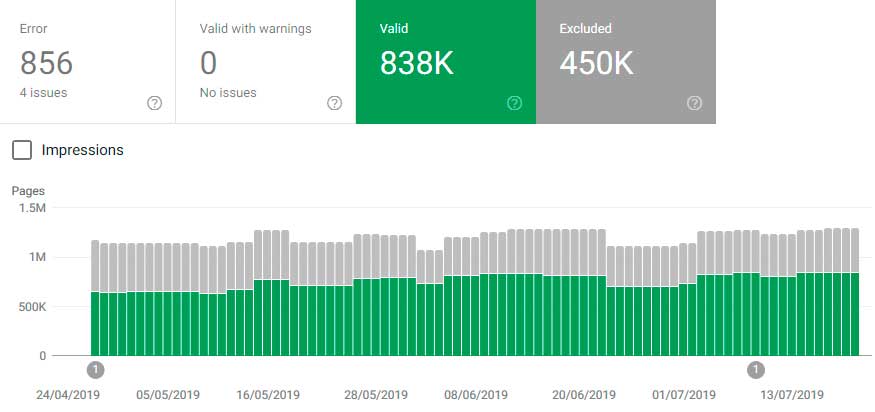

Вот скриншот статистики из Google Search Console, который Оливер сделал в прошлом году (декабрь 2019):

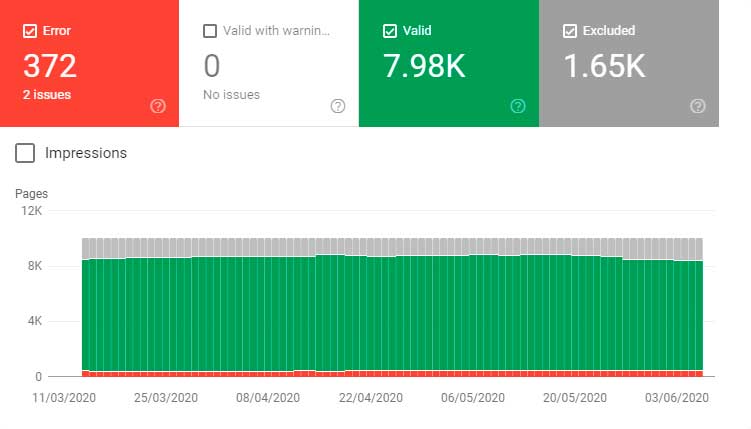

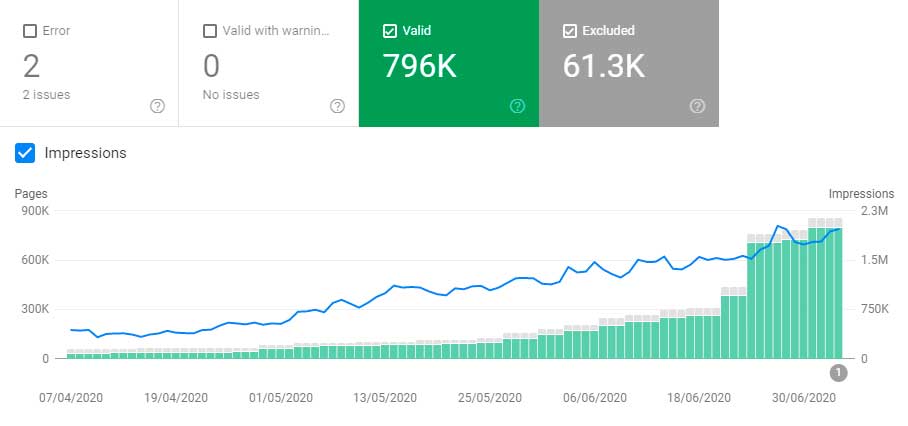

И вот тот же отчёт примерно через полгода (июнь 2020):

В первом случае количество отправленных URL-адресов – 159 тысяч, во втором – 156.6 тысяч. При этом количество проиндексированных URL-адресов увеличилось со 105 тысяч до 124 тысяч. То есть теперь Google видит дополнительные 19 тысяч страниц, которые могут получать от него органический трафик.

Конечно, это не экспоненциальный рост, но цифры всё равно чрезвычайно интересные. Дальше будут ещё графики, позволяющие всё наглядно продемонстрировать. Это просто для лучшего понимания сути.

Сайт, по которому выше приведена статистика – интернет-магазин с большим ассортиментом товаров. Навигация оформлена в лучших традициях классического SEO: страницы категорий, пагинация и продуктовые карточки.

Качество контента за обозначенный период не повышалось. Никакого активного линкбилдинга не проводилось. Внутренние ссылки на эти страницы, которые Google проиндексировал, существенно не улучшались.

Что же изменилось?

Думаю, многие сеошники, работающие в нише e-commerce, знают, что для упрощения аудита и понимания того, какой контент индексируется, файлы Sitemap XML можно делить по типам страниц. На этом сайте такая штука уже была реализована. А ещё владельцы магазина следовали рекомендациям Гугла:

Для всех форматов действуют следующие ограничения: файл Sitemap может содержать не более 50 000 URL, а его размер в несжатом виде не должен превышать 50 МБ.

Эти цифры очень часто можно встретить в рекомендациях SEO-специалистов по разбивке карты сайта. И поэтому многие владельцы интернет-магазинов делают именно так, как написано в инструкции поисковой системы.

Вместо нескольких XML-файлов Sitemap, содержащих не более 50,000 URL-адресов, автор перешёл к большему количеству XML-файлов Sitemap, содержащих 10,000 URL-адресов. В результате 5 Sitemap XML разбили на 15.

Эти небольшие XML карты сайта организованы в хронологическом порядке: products1.xml содержит самые старые продукты, а products14.xml – самые новые. После таких изменений индексация начала происходить иначе.

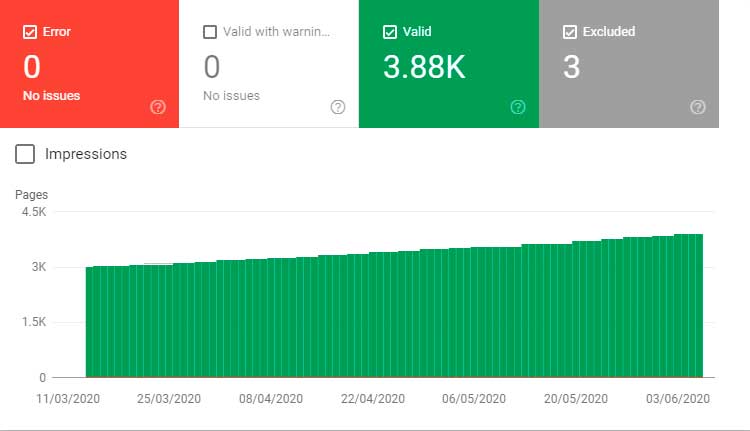

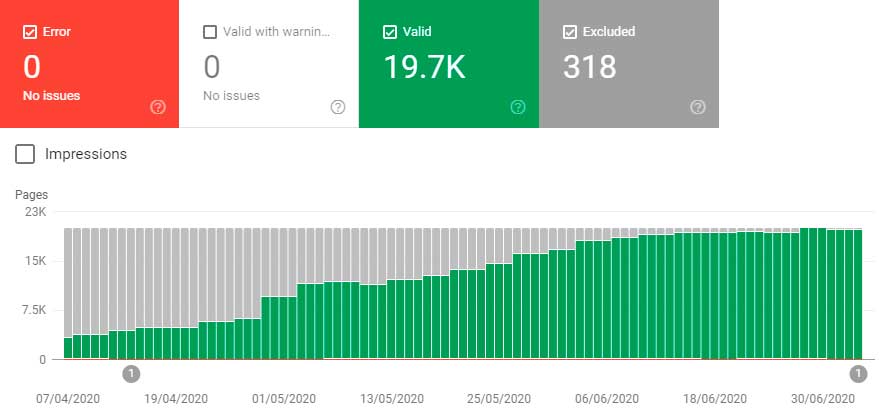

XML карта сайта старых товаров:

XML карта сайта новых товаров:

В таких графиках есть определённый смысл. Более старые продукты с большей вероятностью будут погребены глубже во внутренней архитектуре сайта и в результате получат меньше внутреннего PageRank.

Хотя есть и другое объяснение. На данном сайте много товаров, снятых с продажи. Это повышает вероятность того, что старые страницы будут «более низкого качества» и с большей вероятностью идентифицируются, как «мягкие» 404, в то время как новые добавляемые продукты имеются в наличии.

Вы, вероятно, заметили, что спад идёт постепенный? Происходит так, скорее всего, потому, что материалы на сайте не улучшаются, товарные запасы не пополняются.

Здесь уместно привести недавнюю цитату аналитика Google Гэри Иллиса из Твиттера:

Выбор индекса, хотя это в основном про объём места (RAM/flash/disk), тесно связан с качеством контента. Если у нас есть много свободного места, мы с большей вероятностью проиндексируем некачественный контент. Если нет, мы можем деиндексировать материалы, чтобы освободить место для более качественных документов.

То есть объём доступного краткосрочного хранилища влияет на индексирование контента более низкого качества. Вы можете использовать эту идею для определения областей веб-сайта, которые можно было бы классифицировать как «дерьмовые». Их Google может проиндексировать, а может и не проиндексировать.

Как это работает?

Эту идею мало обсуждают. И в основном это делают именно сеошники. Например, Барри Адамс. Вот цитата и парочка скринов из его статьи:

Я обнаружил, что ограничение файлов Sitemap только 10,000 URL-адресов приводит к более тщательной индексации. Я не уверен, почему, но подозреваю, что небольшие списки URL-адресов легче обрабатывать и сканировать для Google. Снова и снова оказывается, что меньшие карты сайта приводят к более высокой степени индексации.

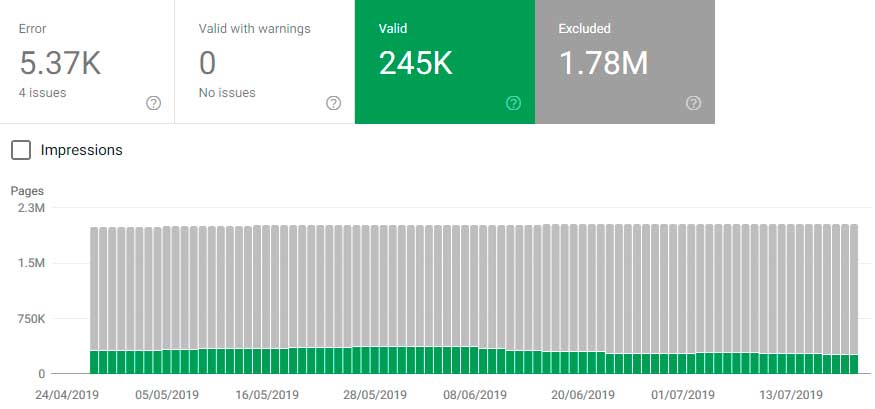

Индексация XML карт сайта на 50,000 URL-адресов в каждой:

Индексация XML Sitemap на 10,000 URL-адресов в каждой:

Вот основные мысли Мейсона на этот счёт:

- Значительно проще обрабатывать файлы Sitemap с меньшим количеством строк. Они также, как правило, быстрее загружаются.

- Более легкие файлы Sitemap (с точки зрения размера файла) загружаются быстрее и их легче обрабатывать. Это похожий на первый пункт, но всё же от него отличается.

- Часто-обновляемые карты сайта чаще сканируются. Вы можете поэкспериментировать с изменяющимся порядком сортировки, чтобы смоделировать это. Переделывая ваши Sitemap XML таким образом, вы можете добавить им немного «новизны».

- Google не будет ждать, когда ваш сервер поднатужится и с трудом передаст большой файл. Ему не нравится тратить ресурсы на синтаксический анализ 50,000 строк.

Цитата с sitemaps.org:

Каждый предоставляемый вами файл Sitemap должен содержать не более 50 000 URL и не должен превышать 50 МБ (52 428 800 байт). При желании вы можете сжать файлы Sitemap с помощью gzip, чтобы снизить требования к пропускной способности; однако каждый файл Sitemap в несжатом виде не должен превышать 50 МБ.

XML карта сайта для Google Новостей

Рассмотрим формат файла Sitemap XML для Google Новостей. Если вы работаете с Google News, то знаете, что система активно сканирует эти карты. Очень активно! Почему? Давайте взглянем на официальные рекомендации:

Файл Sitemap должен содержать URL статей, опубликованных за последние два дня. Статьи, опубликованные более двух дней назад, можно удалить из файла. При этом они будут оставаться в индексе Google Новостей в течение стандартного срока – 30 дней.

И ещё вот это:

Файл Sitemap следует обновлять по мере публикации статей. Файлы Sitemap сканируются поисковыми роботами Google Новостей с той же периодичностью, что и другие данные вашего сайта.

По сравнению с обычными XML-файлами Sitemap, XML-файлы Sitemap для новостей часто меняются и содержат новый контент. Для многих крупных изданий каждый раз, когда Googlebot запрашивает XML-карту сайта, она будет отличаться. Скорее всего, новизна играет большую роль в этом процессе.

Чтобы добавить больше 1000 URL, создайте несколько файлов Sitemap и объедините их с помощью файла индекса Sitemap. Используйте формат XML, описанный в протоколе Sitemap. Общий файл Sitemap может содержать не более 50 000 файлов Sitemap. Эти ограничения гарантируют, что веб-сервер не будет перегружен обработкой больших файлов.

Видите, Google прямо нам с вами говорит, что не рекомендуется использовать большие файлы. Логично предположить, что файлы меньшего размера – лучше.

При публикации новых статей не нужно создавать отдельный файл Sitemap. Просто добавляйте URL новых статей в имеющийся файл.

Вебмастерам рекомендуется сохранять статический URL-адрес этой «шлюзовой» карты сайта, в то время как её содержимое изменяется.

Вероятно, это совершенно разные системы, и, возможно, тут работает не совсем обычный робот Google. По большому счёту это не имеет значения. Всё равно можно применить теорию к тому, как сеошники оптимизируют обычные карты сайта.

Альтернативный подход к XML Sitemap

Этот подход будет полезен тем вебмастерам, для которых очень важна скорость индексации. Ну и для тех, кто столкнулся с тем, что Google массово не индексирует страницы на сайте. Подобные случаи не сильно распространены, но всё же проблема существует. И есть решение!

Вы можете динамически заполнять XML-файлы Sitemap в зависимости от того, что сканирует робот Googlebot.

Вот краткая инструкция по реализации:

- У вас есть список URL-адресов, которые должен просканировать Googlebot.

- Вы генерируете XML Sitemap на основе самых свежих из этих URL-адресов (в данном конкретном примере ниже – 20,000).

- Затем просматриваете журнал на предмет посещения Googlebot.

- Каждый раз, когда робот запрашивает один из отслеживаемых URL-адресов, этот URL-адрес удаляется из вашего списка с помощью /uncrawled.xml.

- Дальше адрес добавляется в соответствующий долгосрочный XML-файл Sitemap (например, /posts-sitemap-45.xml). Этот шаг не является обязательным.

Чтобы всё работало так, как нужно, попросите профессионального программиста помочь вам с этим.

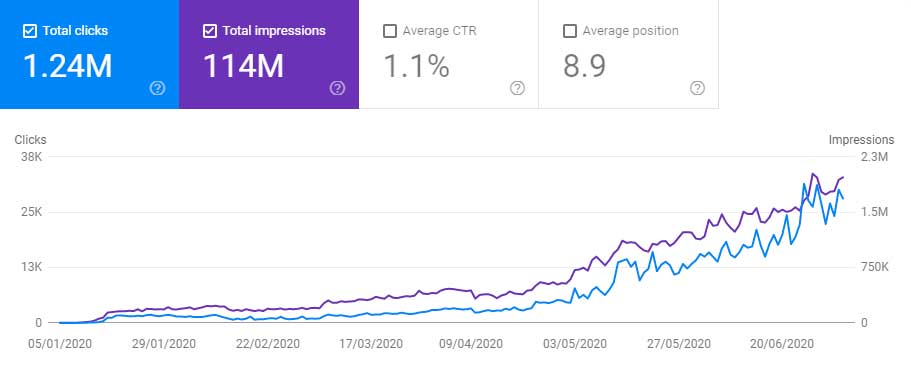

В итоге весь ваш новый высокоприоритетный контент индексируется с максимально возможной скоростью. И без дополнительных приблуд. После первоначальной настройки всё начинает работать довольно быстро:

Обратите внимание, что 20 тысяч URL-адресов в этом файле Sitemap постоянно меняются.

Здесь важно правильно понимать второй график. В XML Sitemap в день появляется гораздо больше, чем 20,000 URL, но размер карты сайта ограничен 20,000 записями.

Количество URL-адресов, по которым Google Search Console отображает тут информацию, представляет собой карту сайта только в определённый момент времени. При этом скорость индексации этого списка URL-адресов быстро увеличивается. В реальности ежедневно сканируется намного больше, чем 20,000 URL.

Конечно, успех этого веб-сайта заключается не только в правильном XML Sitemap…

Альтернативный подход к внутренним ссылкам

Вот вторая идея, основанная на том же подходе, что и первая:

Вы можете динамически управлять своими внутренними ссылками в ответ на URL-адреса, которые сканирует робот Googlebot.

При этом используется та же методология, что и при создании XML-карты сайта, но для заполнения виджета внутренних ссылок с сильно ограниченным размером. То есть организуется динамическая внутренняя перелинковка.

При таком подходе робот Гугла, посещая ваш сайт, будет постоянно насильно загоняться на ещё не проиндексированные страницы. Это что-то вроде кампании агрессивного ретаргетинга.

Виджет для перелинковки должен быть сквозным, то есть располагаться на всех страницах. Но боту не потребуется обходить много URL-ов. Так как новые адреса ему будут подсовываться регулярно, обновления начнут происходить чаще.

Причём, вам даже не обязательно показывать обычным посетителям этот виджет. Хотя его расположение всё же будет влиять на успех всего мероприятия.

Ну и не лишним будет подчеркнуть, что всё это сработает только при условии, что вы правильно базово оптимизируете свой сайт. Чтобы получать не только индексацию, но и хотя бы минимальный органический трафик, требуется годный контент, обратные ссылки и всё такое прочее.

Источник информации: ohgm.co.uk.

Пользуйтесь на здоровье!

СТАТЬИ ИЗ РУБРИКИ:

- Гостевые посты: пустая трата времени или легальная и безопасная стратегия линкбилдинга

- Правильные главные мета теги для сайта и как их заполнять [10 примеров]

- Что не является фактором ранжирования в Google [подборка]

- Как попасть в топ 1 поиска Google или Яндекса: грязный секрет

- Скорость загрузки страниц сайта: Google разрушает SEO-мифы

- Поисковая оптимизация PDF файлов [инструкция от Ahrefs]

- Сообщество для клиентов поможет повысить продажи

- Ahrefs опубликовал самые популярные поисковые запросы на Ютубе в 2020 году

- Чек-лист на 64 пункта для контента, который точно взлетит

- Контент маркетинг в LinkedIn и других социальных сетях [стратегия продвижения]

Очень интересная статья, спасибо! Как раз встала задача загонять в индекс очень быстро новые страницы и вторая идея с динамической перелинковкой мне уже пришла, вы подтвердили, что может сработать, а вот с sitemap.xml я как бы по правилам работал, разбивка на 50000 и всё такое ) Применю новый подход с меньшим количеством страниц.